- エーオーシステム コーポレートサイト

https://www.aosystem.co.jp/ - エーオーシステム プロダクトサイト

https://ao-system.net/ - レンタルサーバー

- バーチャル展示会

- ウェブカタログサービス

- 3Dグラフィック

- Android アプリ

- iOS (iPhone,iPad) アプリ

- Flutter開発

- プログラミング記録QuickAnswer

- 無料画像素材

- スカイボックス 3D SKY BOX

このページのQRコード

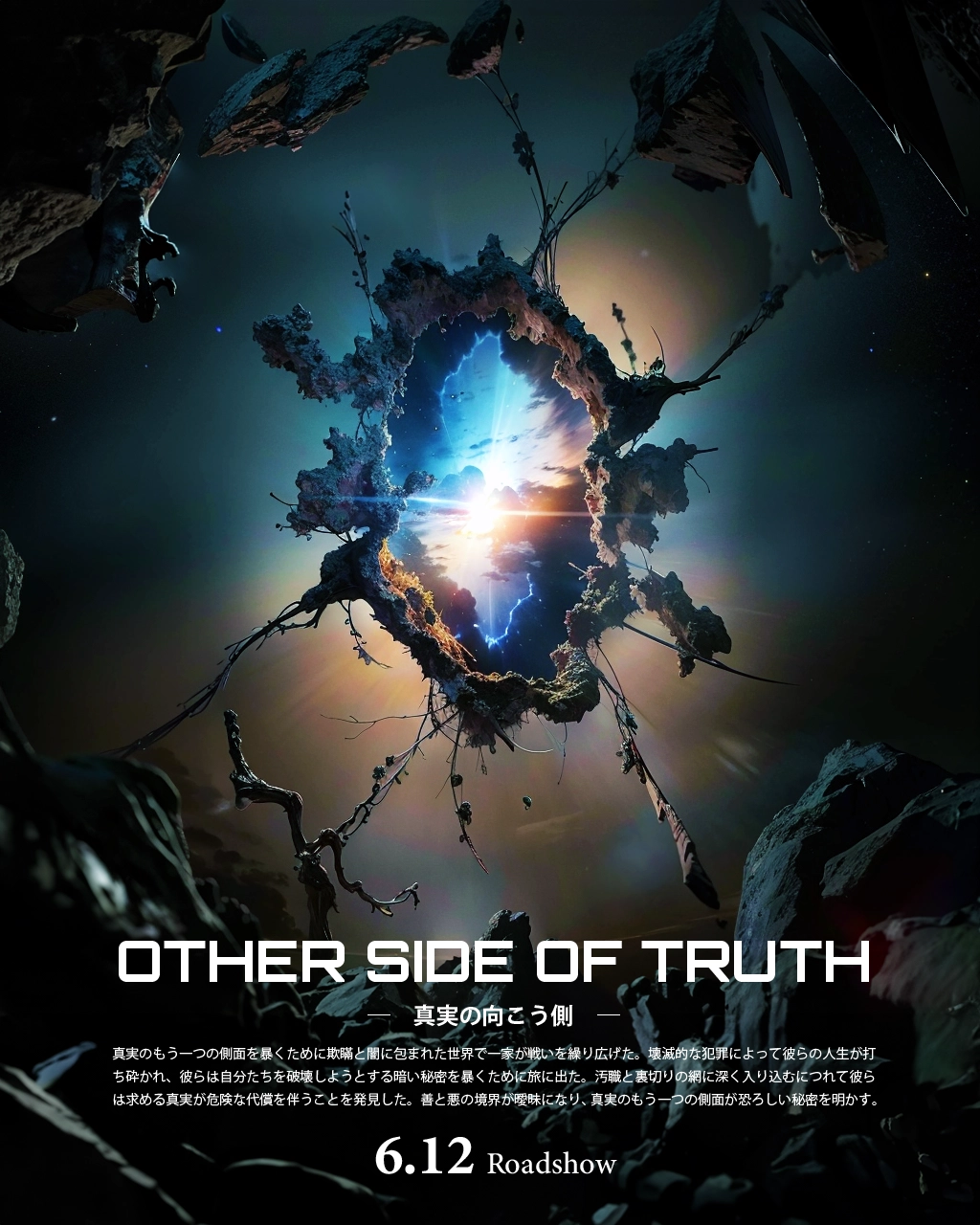

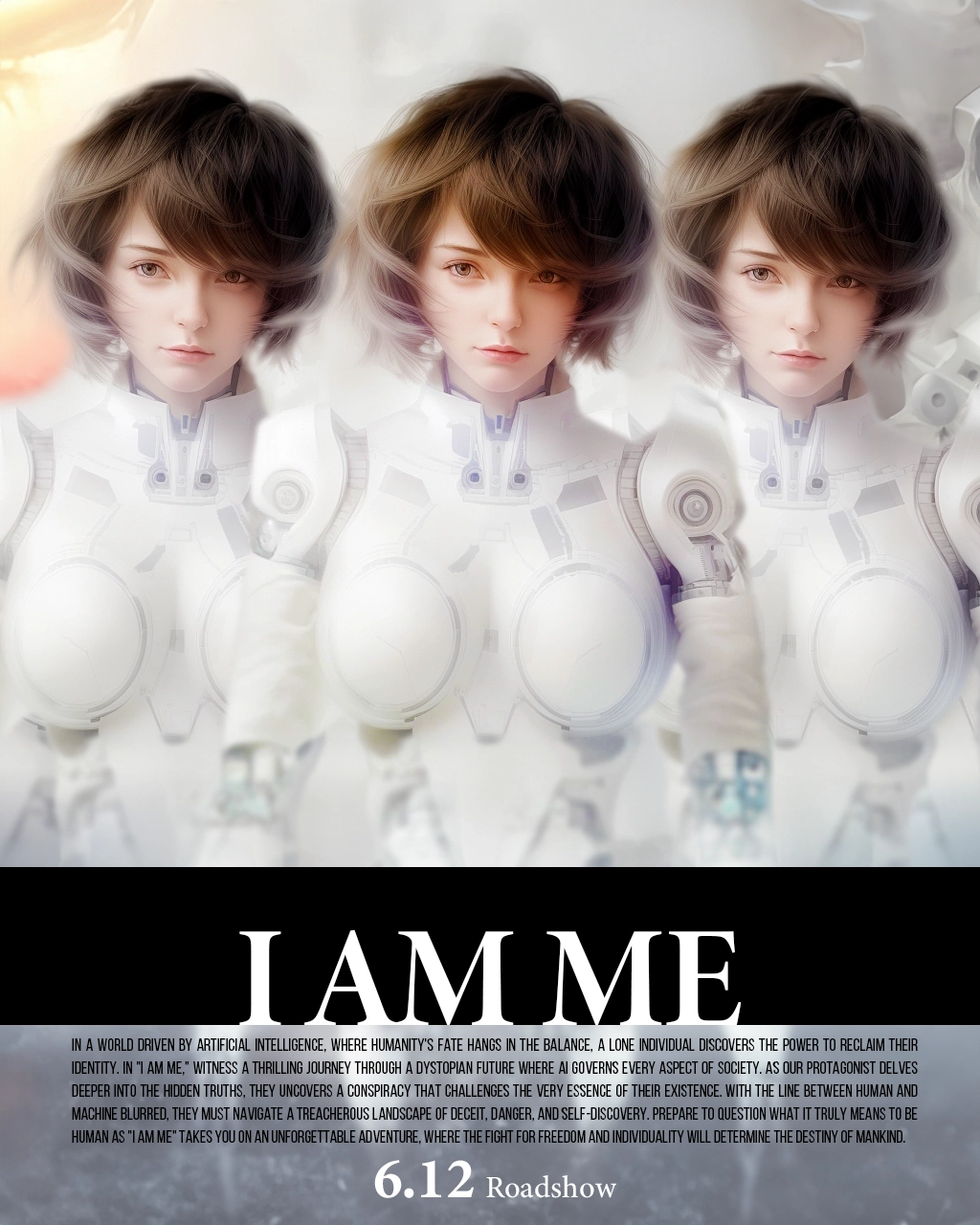

(これら情報は2023-06-12時点のものです)

(これら情報は2023-06-12時点のものです)

(これら情報は2023-06-12時点のものです)

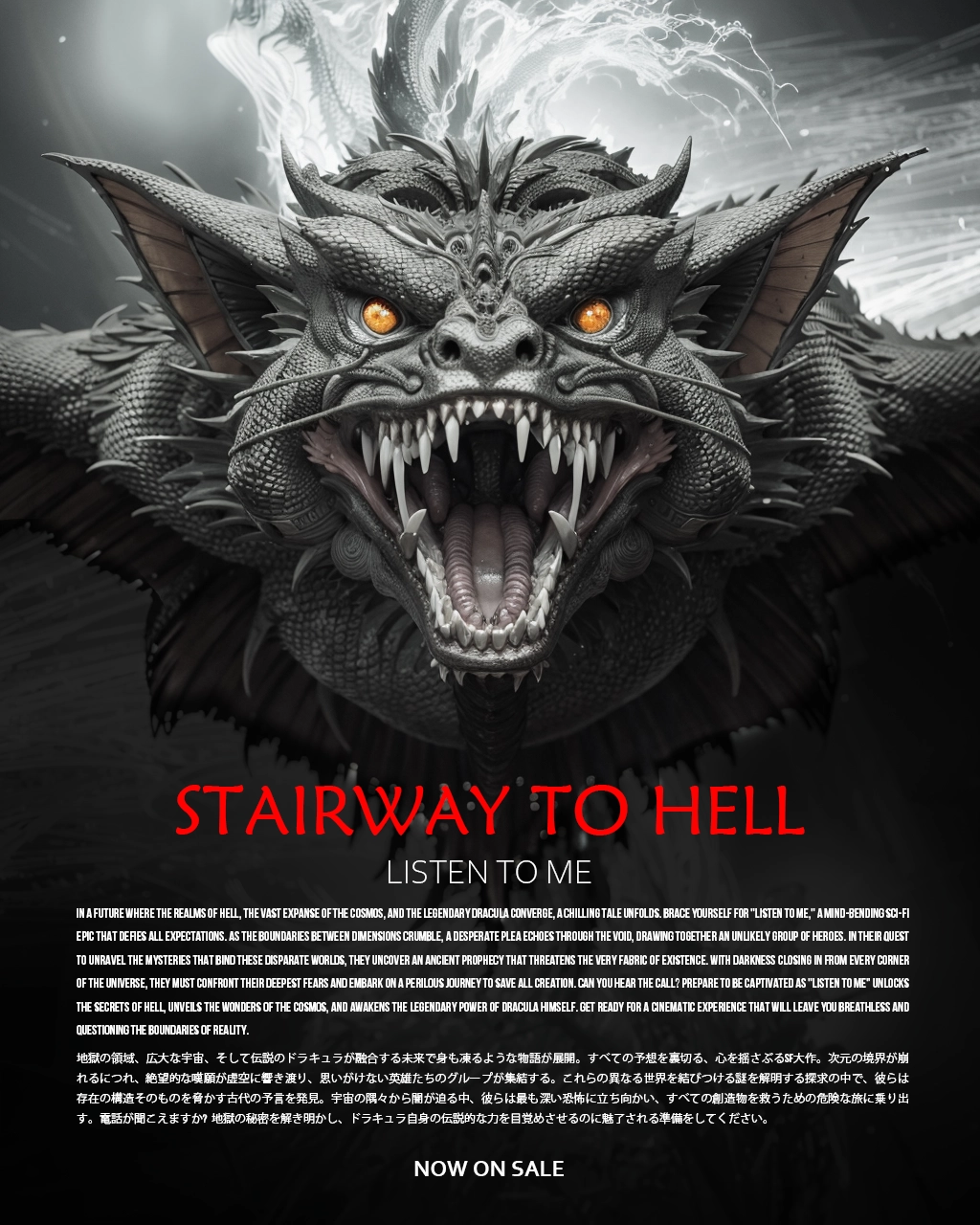

(これら情報は2023-06-13時点のものです)

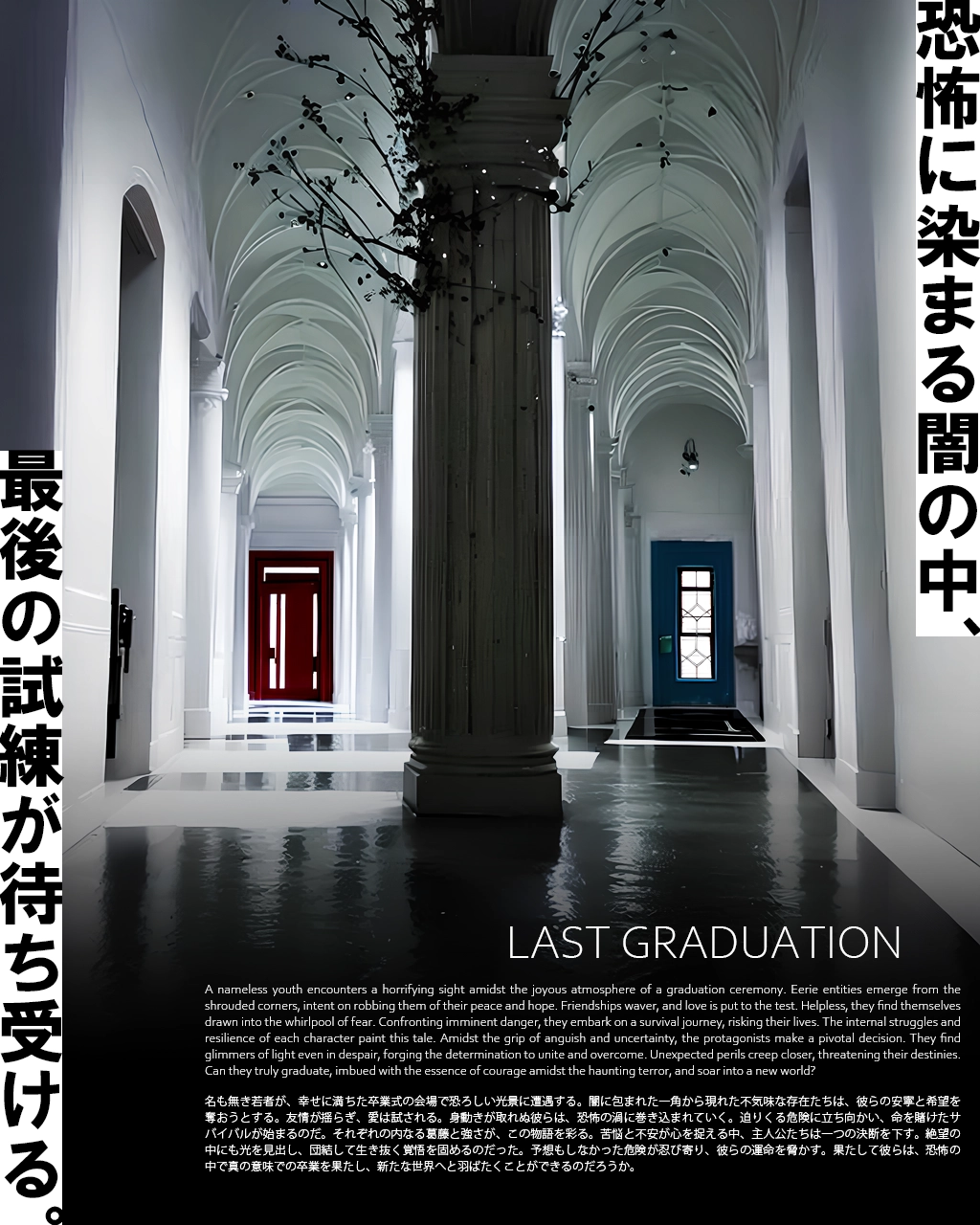

(これら情報は2023-06-15時点のものです)

(これら情報は2023-06-20時点のものです)

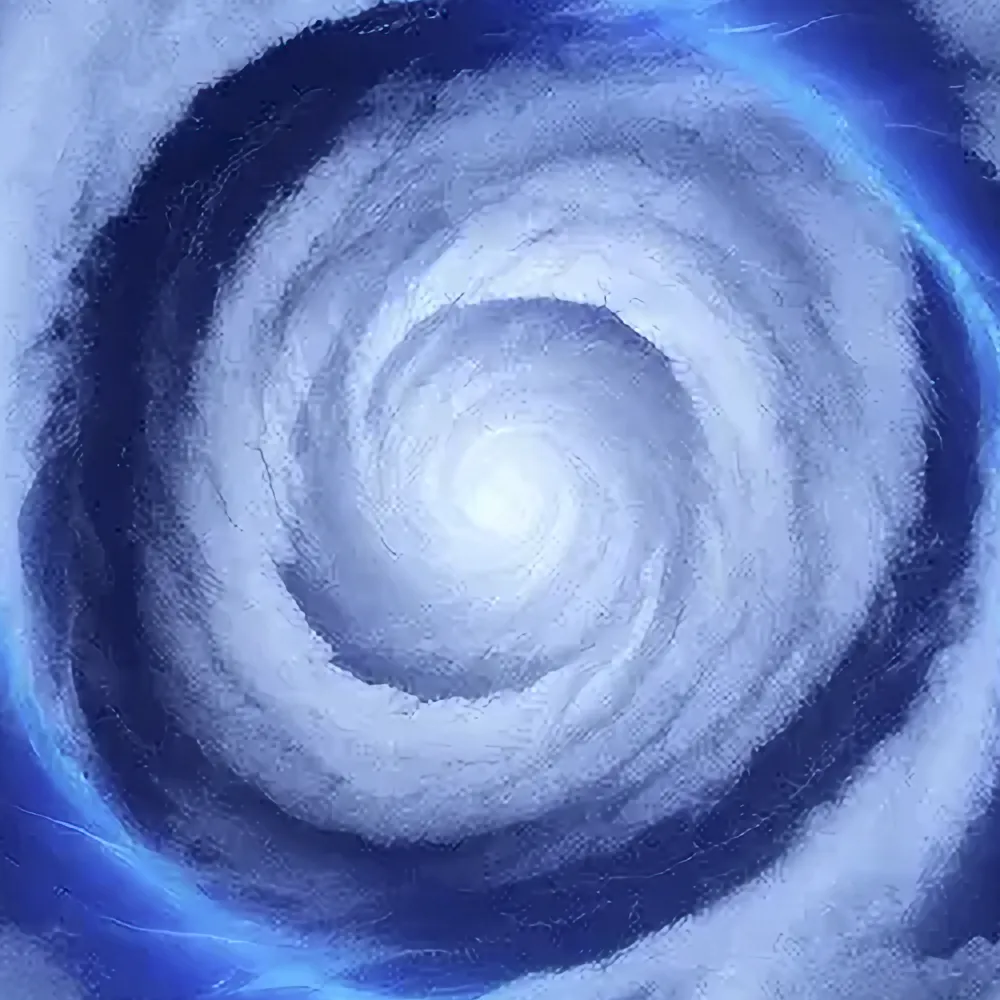

画像を拡大する場合の参考です。単純に画像を拡大すると粗が目立ちますがいわゆるAI機能を用いるとそれなりに使用できる画像が出来上がります。ウェブサイトで使用する程度であれば使える範囲でしょう。

もっと高精細な画像が欲しい場合はこの画像を元に似た画像をAI機能で作ればいいでしょう。全く同じものは再現できませんが似た画像は生成してくれます。

Stable Diffusion での拡大(いわゆるAIで描き直し)が一目瞭然に綺麗。

◇ 用語説明

Extras: Stable Diffusion Web UI (AUTOMATIC1111) 拡張機能のアップスケール機能。

SwinIR_4x: Extrasに含まれる拡大アルゴリズムのひとつ。

◇ 参考

8倍拡大にかかる時間は110秒。グラフィックボードは GeForce RTX4070 。

(これら情報は2023-05-30時点のものです)

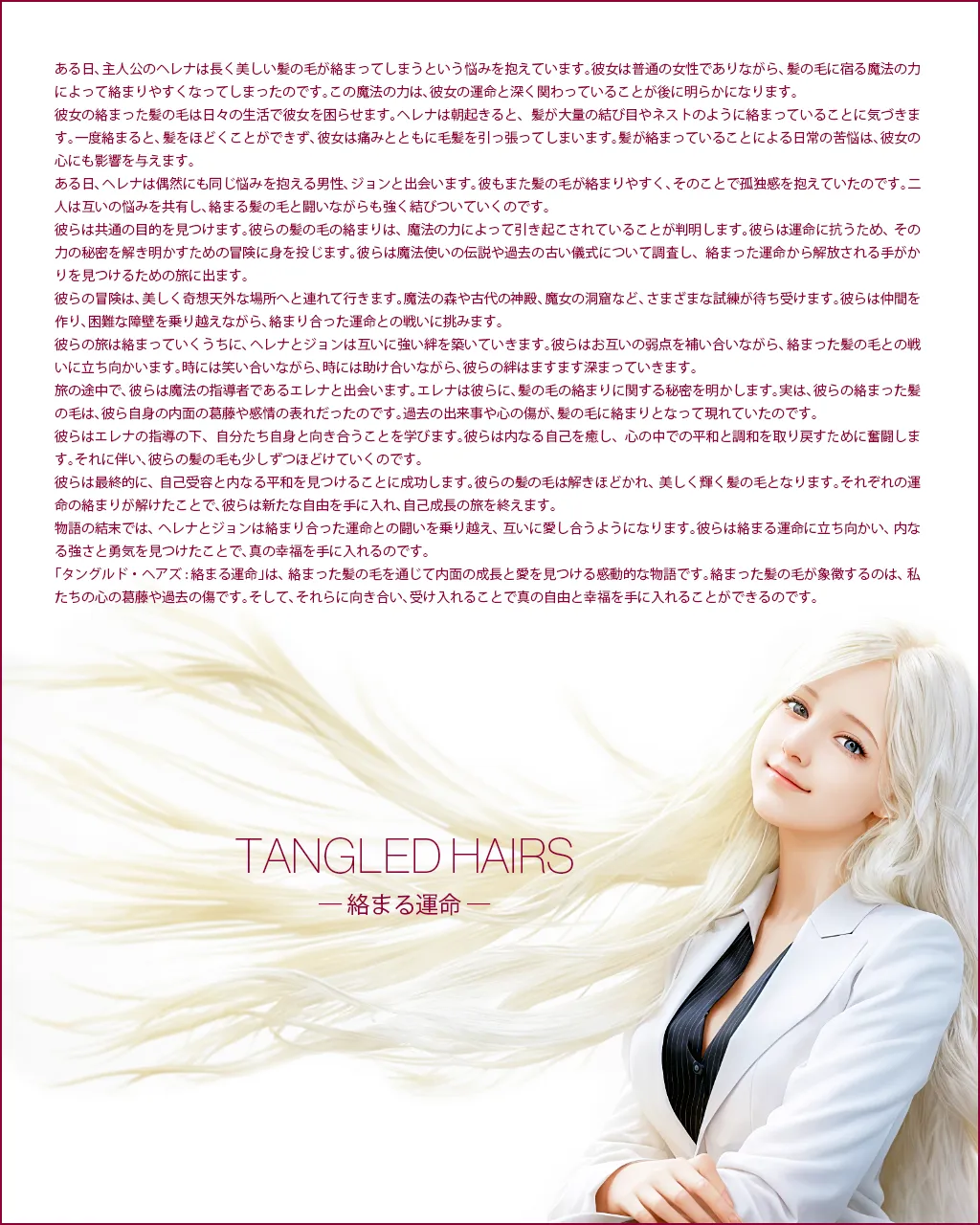

掲載している画像には顔がぐちゃぐちゃでそのままではとても使用できないものも含まれます。

でも心配無用です。いわゆるAIに描き直して貰えばいいのです。

Stable Diffusion で描き直せば十分使える品質に向上できます。細部が変化していますので拡大ではなく描き直しであることがよく分かるでしょう。さらに2倍に描き直してもいいでしょうし、これならPhotoshopで少し補正すれば十分ウェブサイトで使用できるでしょう。

◇ DATA

Stable Diffusion Web UI (AUTOMATIC1111)使用。

プロンプトを適宜入力。

ControlNetにオリジナル画像をセット。ControlTypeは Tile を選択。

Sampling method は DPM++ SDE Karras 。

Upscaler は今回はデフォルトの Latent で良い結果が出ましたが他でもいいでしょう。

(これら情報は2023-06-01時点のものです)

一部分だけ描き直すことをINPAINTと言います。

髪の毛がなじんでいないので描き直しましょう。

画像の周囲に描き足すことをOUTPAINTと言います。上記のオリジナル画像の体を描き足します。

(これら情報は2023-06-01時点のものです)

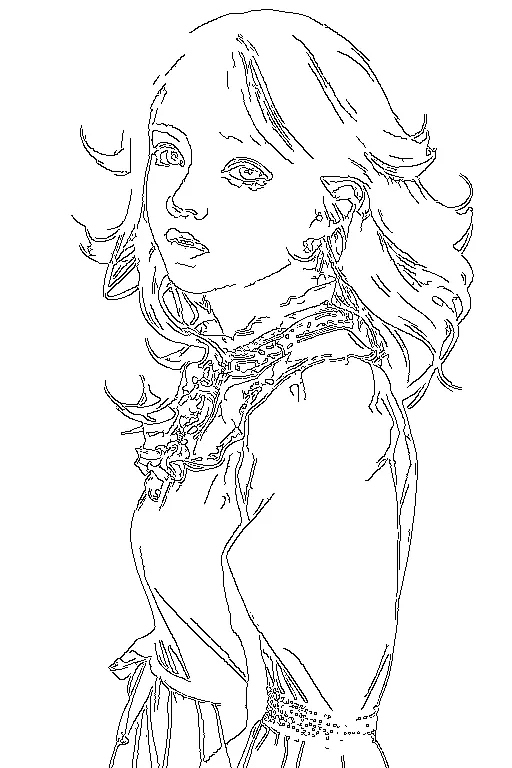

輪郭抽出して実写に描き直してしまいましょう。

◇ DATA

Stable Diffusion Web UI (AUTOMATIC1111)使用。

ControlNetにオリジナル画像をセット。ControlTypeは Lineart を選択。

プロンプトを適宜セットしてそのままGenerate。

この黒地に白の線画は実際は内部処理なので意識せずに進行できます。

(これら情報は2023-06-01時点のものです)

もうお気づきのことと思いますが、手書きイラストをそのまま実写化できます。

◇ DATA

Stable Diffusion Web UI (AUTOMATIC1111)使用。

ControlNetに手書きイラストをセット。

ControlTypeの Preprocessor に Invert 、Model に lineart を選択。

プロンプトを適宜セットしてGenerate。

(これら情報は2023-06-01時点のものです)

もっと簡単な線画からも生成可能。

◇ DATA

Stable Diffusion Web UI (AUTOMATIC1111)使用。

ControlNetに手書きイラストをセット。

ControlTypeの Preprocessor に Invert 、Model に canny を選択。

プロンプトを適宜セットしてGenerate。

これなら君にも描ける。

◇ DATA

Stable Diffusion Web UI (AUTOMATIC1111)使用。

ControlNetに手書きイラストをセット。

ControlTypeの Preprocessor に Invert 、Model に canny を選択。

プロンプトを適宜セットしてGenerate。

(これら情報は2023-06-01時点のものです)

The voice was read out by Amazon Polly on AWS. SadTalker, one of the Stable Diffusion Web UI extensions, can synthesize audio with images to generate videos.

音声はAWSのAmazon Pollyで読み上げました。Stable Diffusion Web UI 拡張機能のひとつであるSadTalkerで画像に音声を合成して動画を生成することが可能です。

La voz fue leída por Amazon Polly en AWS. SadTalker, una de las extensiones de la interfaz de usuario web de Stable Diffusion, puede sintetizar audio con imágenes para generar videos.

◇ DATA

AWS Amazon Polly でテキストからオーディオデータ生成。

Adobe Audition で3つの音声を連結。

Stable Diffusion Web UI (AUTOMATIC1111) の拡張機能 SadTalker で合成。

(これら情報は2023-06-01時点のものです)

(これら情報は2023-06-01時点のものです)

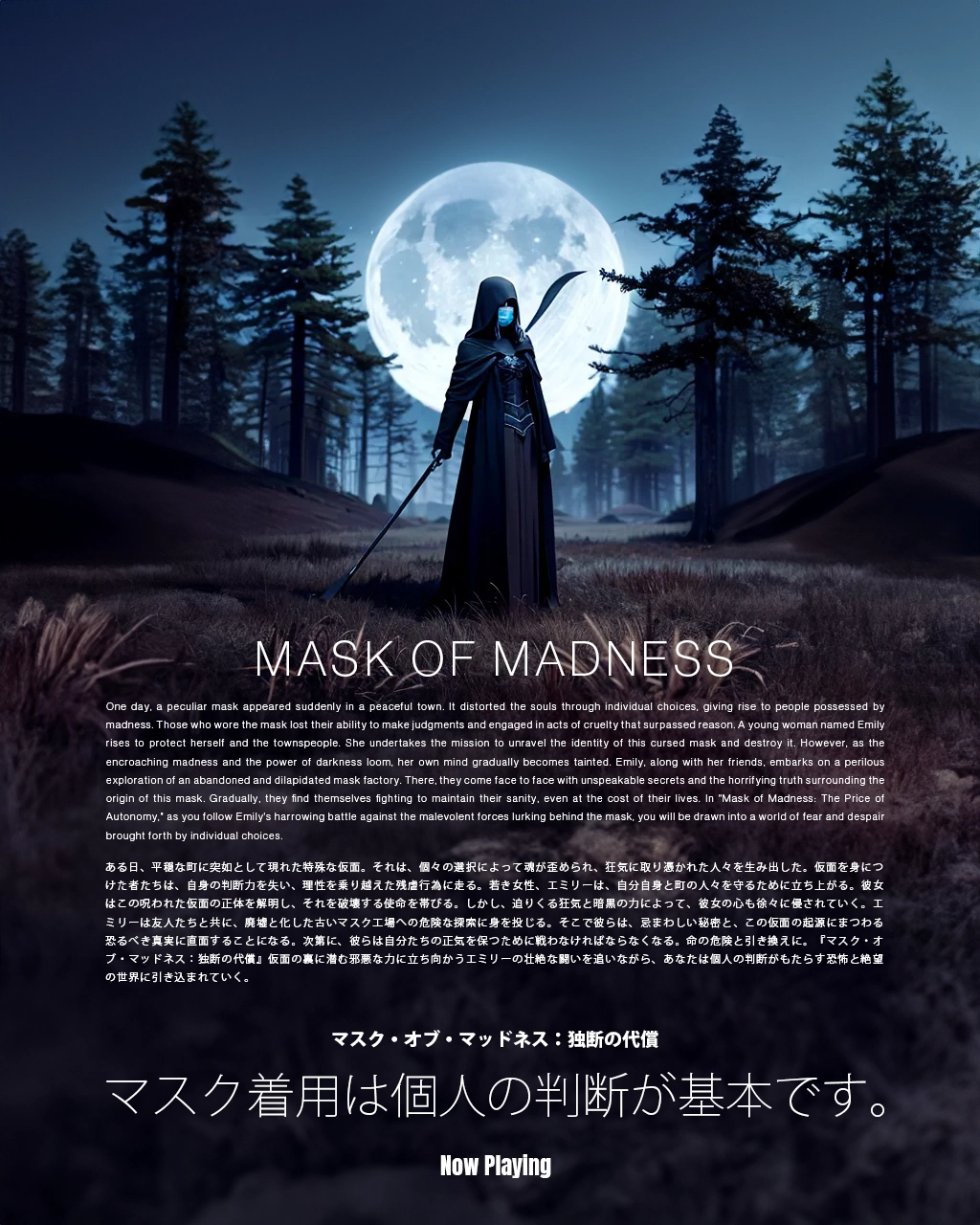

Midjourney、Stable Diffusion、

どれもオンラインで手軽に使えますが、目的の画像を生成するにあたって様々な条件で試す必要が有り、何枚も生成してから選ぶガチャになりがちです。

そもそも画像をテキストだけで指示するという行為そのものが無謀であることが使えばわかってきます。

この数か月で Stable Diffusion Web UI 及びその拡張機能は大幅に進化し、テキストからの画像生成だけではなく元となる画像の補正や派生を生成する機能が充実してきました。 様々な分野に特化したモデル(学習モデル)を選べることも Stable Diffusion Web UI をお勧めする理由です。イラストに特化、実写人物に特化、建築物に特化、など様々なモデルを切り替えて使用できます。 ただし使いこなすには経験値が必要になりますので、安易に目的画像を生成できるとは考えない方がいいでしょう。

オンラインサービスの機能も充実してきて細かな指定も出来るようになってきました。ただし100枚200枚と生成してその中から選ぶという手法は良くありますし、業務で使う画像をオンラインで使うというのは秘匿上問題となるケースも有るでしょう。 ローカルインストールの Web UI ではバッチ処理やバリエーション作成の機能も充実しています。また画像生成だけではない付加機能も充実していますのでオンラインサービスよりも100倍の自由度と利便性が有ると言ってもいいかも知れません。

Stability.ai がオープンソースで公開している Stable Diffusion はそのままでは使いづらい為、ウェブブラウザで使いやすくしたUIをAUTOMATIC1111さんが「Stable Diffusion web UI」という名称でオープンソース公開しています。

この機能が有名になったため、いつしか Stable Diffusion web UI の事を AUTOMATIC1111 と呼ぶ例が増えてきました。YouTube等の解説動画では Stable Diffusion web UI ではなく AUTOMATIC1111(イレブンイレブン) と呼ぶケースが多いです。

AUTOMATIC1111とは投稿者の名前ですので正確な読みは不明です。本人が eleven eleven と呼んでいるかは疑問なところで(要情報)、私なら「いちいちいちいち」と呼ぶでしょう。

以下、Stable Diffusion Web UI (AUTOMATIC1111) を Web UI と記します。

Windowsパソコンの場合で説明します。

それなりに高性能なパソコンが必要です。グラフィックボードのメモリ搭載量が12GB以上の物をお勧めします。ディスク空き容量は50GB程度は確保しておきましょう。

ここでの解説は概要のみです。(2023年3月~5月時点の情報)

・Phthon 3.10 をインストール

https://www.python.org/downloads/windows/

WindowsのPATHにPythonを通します(追加します)。

・Git をインストール

https://git-scm.com/download/win

・Web UIのダウンロード

Web UIをインストールしたいディレクトリ(フォルダ)でターミナルにて実行。

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

・Web UIの起動

webui-user.bat をダブルクリック。自動で初期設定が行われます。

「Running on local URL: http://127.0.0.1:7860 」と表示されたらウェブブラウザで http://127.0.0.1:7860 にアクセスすれば使用できます。

・Web UIの終了

ターミナルとブラウザを閉じます。

・Web UIの起動(2回目以降)

webui-user.bat をダブルクリックします。

「Running on local URL: http://127.0.0.1:7860 」と表示されたらウェブブラウザで http://127.0.0.1:7860 にアクセスすれば使用できます。

・画像生成

最初のテキストボックスに生成したい画像を英字で入力してGenerateボタンをクリックします。画像が表示されれば成功です。

・さらに、ControlNet等の各種拡張機能、学習モデル(単にモデルと言われることが多い)、LoRA(Low-Rank Adaptation)、などの追加インストールが必要になります。

具体的な使用方法やコツについてはここでは紹介しきれません。毎週のように拡張機能が登場し更新されています。常に最新情報を集めてトライすることが大切になってきます。

このページのQRコード

便利ウェブサイト

便利 Android アプリ

便利 iOS(iPhone,iPad) アプリ